I sistemi di monitoraggio delle infrastrutture offrono un contributo fondamentale per migliorare la conoscenza e sicurezza dei ponti. Tuttavia, il numero crescente di sistemi installati limita la possibilità di controllo umano sul singolo segnale e apre le porte a possibili anomalie di segnale non rilevate che perturbino la qualità delle misure e generino falsi allarmi.

Dal 1959, Kistler Instrumente AG ha assunto un ruolo guida nel mercato globale della misura, con particolare riferimento alla misura dinamica di forza, accelerazione e pressione. La tecnologia con la quale Kistler si è inizialmente affermata fa riferimento all’effetto piezoelettrico, reso utilizzabile dal progetto e successivo sviluppo del primo amplificatore di carica da parte dei fondatori, Hans Conrad Sonderegger e Walter P. Kistler, nel 1950 (https://www.kistler.com/IT/it/soluzioni-per-il-monitoraggio-strutturale-delle-infrastrutture/C00000013).

I sensori piezoelettrici sono molto apprezzati per diverse ragioni, tra le quali la capacità di fornire misure precise in un ampio range di frequenza e alta dinamica; tuttavia, non tutti gli elementi sensibili che esibiscono effetto piezoelettrico sono facilmente utilizzabili in campo misuristico.

Fattori come la variazione di temperatura, le deformazioni superficiali del componente da cui estrarre la grandezza fisica di interesse, le vibrazioni ed altri agenti esterni possono avere effetti profondi su alcuni elementi piezoelettrici (tra i quali citiamo come esempio i piezoceramici), compromettendo in ultima analisi la performance del sensore in determinate applicazioni critiche.

L’esperienza che in questi decenni Kistler ha raccolto nell’ambito della governance delle difficoltà legate al mondo della misura ha assicurato all’Azienda una conoscenza approfondita delle possibili modalità di difetto di segnale, su varie tecnologie, individuandone con precisione le modalità causative, le relative contromisure e i fenomeni di disturbo. Questa esperienza porta beneficio ai sistemi di monitoraggio delle infrastrutture, in particolar modo dei ponti.

Tale sistema rappresenta infatti una situazione limite nella quale accadono contemporaneamente le seguenti circostanze:

- difficoltà nel poter avere un controllo diretto sulla strumentazione installata nel tempo tramite le classiche ricalibrazioni o test funzionali periodici (smontaggio e rimontaggio oneroso, accessibilità al sistema limitata);

- necessità di discriminare piccoli valori della grandezza fisica da misurare (ad esempio accelerazione) rispetto al rumore di fondo, deviazioni generalmente considerate accettabili sulla sensibilità del sensore possono in questo caso essere vicine all’ordine di grandezza dei fenomeni da accertare;

- analisi avanzate, tra le quali l’analisi modale operativa, le strategie machine learning e altre strategie di correlazione di dati provenienti da fonti eterogenee, comunemente applicate su dati di monitoraggio, beneficiano di dati accurati e coerenti nel tempo; al contrario, possono scendere di affidabilità incorporando dati rumorosi o imprecisi;

- l’errore legato alla salute del sensore o del sistema di monitoraggio può essere scambiato per una problematica di tipo strutturale, creando attraversamenti di soglia e falsi allarmi con gravi ripercussioni sull’operatività della struttura;

- inoltre, all’accumularsi dei falsi allarmi si può creare un effetto di tolleranza per il quale le segnalazioni del sistema di monitoraggio vengono ignorate, anche quando effettivamente possono essere corrette e prevenire danni anche catastrofici.

Si necessita quindi l’implementazione di strategie per comprendere lo stato di salute del sistema di monitoraggio, prima ancora dello stato di salute della struttura monitorata.

Tale compito è di competenza misuristica, situazione nella quale Kistler spende in modo particolarmente efficace il proprio bagaglio di esperienza e conoscenza.

Test di plausibilità incorporati nel sistema di monitoraggio

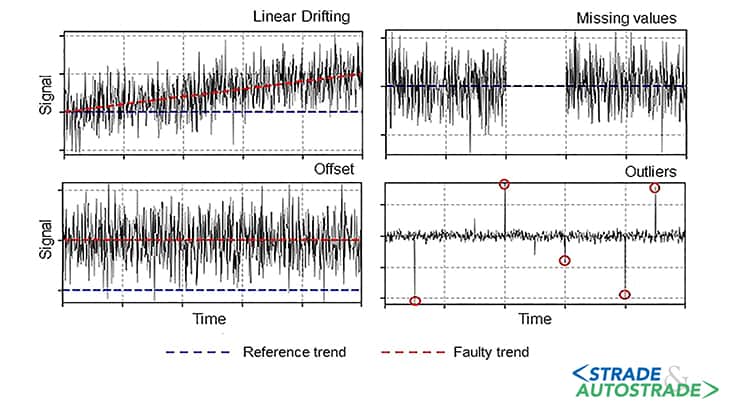

Deviazioni o guasti nel comportamento della catena di misura si presentano tipicamente con diversi segnali [1] – alcuni di questi riconoscibili – tra i quali:

- la deriva del segnale, ovvero la continua deviazione lineare o non lineare dei misurandi del sensore da un valore plausibile. Questo comportamento è tipicamente correlato a uno scarso isolamento del sistema sensore/cavo/adattatore, alla presenza di importanti gradienti termici o a problematiche relative a componenti elettrici o elettronici (ad esempio, gli amplificatori di carica);

- offset costanti del segnale rispetto al valore atteso; quest’ultimo può essere facilmente verificato in fase di collaudo e incorporato, insieme alle informazioni di taratura del sensore, all’interno del sistema deputato ai test di plausibilità;

- valori anomali (outliers), da intendersi come deviazioni improvvise e significative del segnale rispetto al suo valore atteso, sia limitati nel tempo sia per tempo significativo;

- valori mancanti, che si verificano nel momento in cui il sensore smette di fornire dati in tempo reale, a causa di problemi sulla catena di misura. Il sensore può anche successivamente riprendere in modo coerente il proprio lavoro dopo un certo periodo di tempo;

- rumorosità anomala sul segnale, con impossibilità di identificare il segnale significativo rispetto al rumore di fondo;

- trimming, cioè saturazioni di componente di segnale in corrispondenza del raggiungimento di particolari soglie legate al guadagno o al fondoscala del sensore.

Per il corretto rilevamento di questi tipi di problematiche e la conseguente garanzia del corretto funzionamento del sensore è possibile eseguire approfonditi controlli di plausibilità (“plausibility check”) sfruttando il fatto che il dato, nei monitoraggi infrastrutturali, è spesso acquisito in ridondanza.

La logica di lavoro è la seguente: a un passo temporale prestabilito e configurabile, i misurandi raccolti vengono confrontati con dati di sintesi (tramite tecniche Principal Component Analysis) raccolti da osservazioni storiche e/o spazialmente ridondanti, sia relativamente al singolo sensore sia ad un cluster di sensori; da tale confronto si applicano regole statistiche e di individuazione di potenziali tendenze anomale [2].

I 60 anni di esperienza di Kistler nel settore dei sensori forniscono la profonda comprensione fisica dei possibili guasti ai sensori o ai sistemi e guidano verso la localizzazione dei loro effetti. L’individuazione di tali eventi porta dunque direttamente alla loro successiva prevenzione, sia attraverso interventi sul sensore o sull’architettura o, ove possibile e consigliabile, compensandoli durante la post-elaborazione.

In generale, i sensori sui quali è stato identificato un problema generano degli alert interni al sistema dando la possibilità all’Ingegnere Analista di prendere una decisione in modo puntuale e rapido su come trattare l’individuazione di quella specifica anomalia, guidandolo verso la risoluzione più opportuna.

Tipicamente, le risoluzioni possono portare a compensazioni, oppure ad eliminazioni di quello specifico segnale dal computo delle analisi più avanzate, fino alla loro completa esclusione e segnalazione di necessaria sostituzione alla successiva operazione manutentiva sull’opera, limitando allo stesso tempo in modo drastico le possibilità di falsi allarmi.

Perché scegliere soluzioni cloud-based?

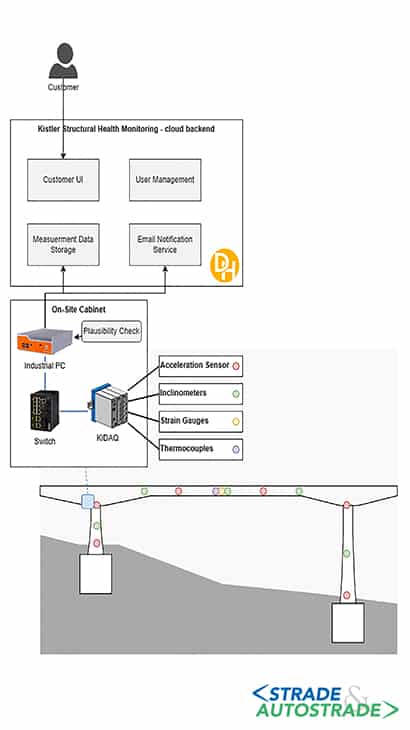

L’applicazione SHM di Kistler è un’applicazione ibrida, che viene eseguita nella sua collocazione standard in parte su edge computer (PC locale sull’opera) in parte su cloud.

Altre configurazioni sono sempre possibili qualora l’architettura complessiva del sistema lo richieda o sia curata da parte dal Cliente finale; tuttavia, la combinazione di edge e cloud garantisce di utilizzare il meglio di entrambi i mondi al servizio del sistema di monitoraggio.

Il dispositivo edge installato in loco consente di gestire enormi quantità di dati in tempo reale con un tempo di ritardo trascurabile. Inoltre, è la chiave per cucire in modo sartoriale il sistema di monitoraggio sull’esigenza specifica dell’opera, gestendo da pochi a centinaia o addirittura migliaia di sensori, mantenendo le stesse prestazioni.

I dati raccolti, opportunamente pre-elaborati e compressi in loco, possono essere utilizzati per successive operazioni complesse (come calcoli in tempo reale sui dati al servizio dei test di plausibilità), senza alcuna necessità di pesare sul cloud per ottenere gli esiti di questi calcoli.

Sebbene il dispositivo edge sia indispensabile per la rapidissima elaborazione dei dati in loco, l’archiviazione a lungo termine e l’accessibilità del dato rimarrebbe pregiudicata senza la possibilità di intervento da remoto.

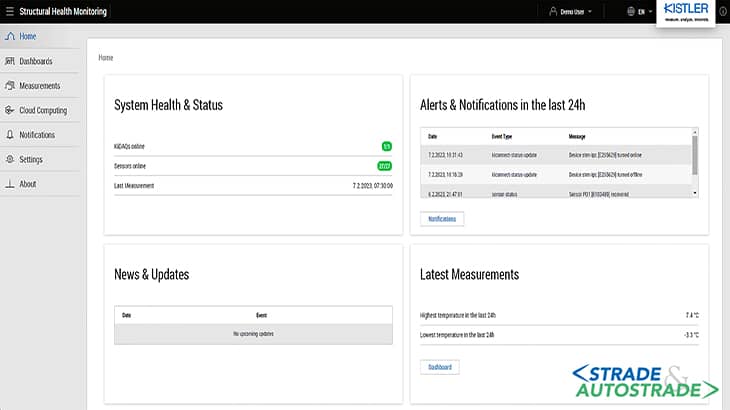

Qui entra in gioco la potenza dell’applicazione cloud. I vantaggi per gli utenti sono molteplici:

- accessibilità: gli utenti, con gli opportuni privilegi accesso e controlli cybersafe, possono accedere ai dati da qualsiasi luogo, indipendentemente dal fatto che si trovino in prossimità della struttura, in ufficio od impegnati altrove. L’interfaccia utente, completamente web-based, consente inoltre all’utente di accedere al sistema senza alcuna necessità di pre-requisiti software da preinstallare;

- affidabilità: il cloud storage offre nativamente la possibilità di eseguire backup e ripristino dei dati garantendone la piena disponibilità anche in caso di successive guasti hardware locali o calamità naturali;

- sicurezza: una delle principali preoccupazioni di Kistler in ambito monitoraggio infrastrutturale è la sicurezza dei dati dei Clienti. Kistler supporta nativamente tutti i componenti delle sue applicazioni tecniche di crittografia e di gestione degli accessi interpretabili solo da utenti con gli opportuni privilegi. Il traffico dati tra il sito di monitoraggio e il cloud avviene in modo totalmente crittografato. Essendoci poi costante comunicazione tra i dispositivi in campo e le applicazioni cloud, è sempre possibile aggiornare da remoto, tramite procedure automatiche, il firmware dei dispositivi, garantendone dunque la copertura dei rischi per la sicurezza che dovessero emergere nel tempo senza ritardi;

- qualità del dato: la possibilità di gestione dei dati da remoto permette inoltre di intervenire sugli elementi segnalati dal plausibility check direttamente dall’ufficio dell’ingegnere analista, ovunque esso sia, modificando le sensibilità, introducendo dei fattori correttivi o semplicemente escludendo il sensore problematico dalle successive analisi.

La combinazione di applicazioni cloud e presenza di edge si è dunque rivelata la miglior possibile customer experience per usufruire di dati corretti, sicuri e robusti sui quali basare le decisioni concernenti la sicurezza delle nostre infrastrutture.

Bibliografia

[1]. A. Blázquez-García, A. Conde, U. Mori, J.A. Lozano – “A review on outlier/anomaly detection in time series data”, ACM Computing Surveys (CSUR), 54(3), pp. 1-33, 2021.

[2]. G. Jesus, A. Casimiro, A. Oliveira – “A survey on data quality for dependable monitoring in wireless sensor networks”, Sensors, 17(9), p. 2010, 2017.

> Se questo articolo ti è piaciuto, iscriviti alla Newsletter mensile al link http://eepurl.com/dpKhwL <